人工知能(AI)の実用化が急速に進み始めています。セキュリティ、マーケティング、エンターテインメントなど様々な分野で、すでに利用が始まっているのはご存じでしょう。

その中で、人間の感情を推定できる感情認識AIは、ヒトの感情に応じて行動する能力を機械に与える革命的な技術だといえます。その革命的な技術もすでに応用が開始されています。

この記事では、感情認識AIの基本概念から応用、技術的課題、倫理的考慮、そして未来の展望までを解説します。

松本豊(まつもと・ゆたか)

1998年早稲田大学人間科学部卒業後、医療サービス会社に勤務。2001年からアメリカに留学し、2005年にCAC Americaに入社。 2012年に日本に帰国しCACへ、複数の新規サービスのマーケティングや運営、プロダクトグロースなどを担当。2022年4月より感情認識AI『Affdex』のセールスを担当、感情センシング技術の展開を推進している。2024年1月からはプロダクトオーナーを務める。

感情認識AIとは?

感情認識AIとは、人間の感情を自動で推定・識別するAI技術です。顔の表情、音声のトーン、言葉遣い、場合によっては心拍数や体温の変化などから感情を読み取り、その人がどのような感情を持っているのかを数値化して分析します。

感情認識AIの誕生と歴史

人間の表情から感情を読みとる行為は、人がコミュニケーションの手段として普段より行っていることです。しかしながら、これまでは感情を客観的に機械で測定することはできませんでした。

マサチューセッツ工科大学(MIT)のロザリンド・ピカード教授は、脳の機能を模倣するコンピュータの研究に携わっていました。

教授は人が物事を認識する過程において感情が重要な役割を果たしているはずだと考え、これを客観的に証明するためにエンジニアリングツールを持ち出したのが感情認識AI誕生のきっかけとされています。ピカード教授の著書「Affective Computing」(1997)によってその研究は広く知られることとなりました。

その後、ピカード教授は、ラナ・エル・カリウビィ博士と共同で、Affectiva(アフェクティバ)社を起業し、そこで感情認識AI『Affdex(アフデックス)』を開発します。

今や、感情認識AI「Affdex」は、教育、医療、自動車など様々な分野で広く活用され始めています。日本では株式会社シーエーシー(CAC)が唯一の代理店となっており、Affdexを販売するとともに、これをプラットフォームとした独自製品の開発を行っています。

>>人の感情を認識するAI「Affdex」|Affectiva×シーエーシー

感情認識AIの仕組み

感情認識AIはコンピュータに人間の表情を機械学習させて作成しています。前述のAffectiva社では90ヵ国、約1,000万の人の表情が写ったビデオを収集し機械学習をさせたといいます。

人の表情を作る筋肉の動きを「アクションユニット」と呼び、これを45種類に分類しています。その45種類のアクションユニットが組み合わせられ、何百種類もの感情を認識できるようになっています。

こうして機械学習させたAIは、多種多様な人間の表情を識別できるようになり、例えば同じ笑顔でも、本当の笑顔なのか、作り笑いなのかも推定することができます。

音声や文章についても同様で、音声の波形と感情、文章の表現と感情の組み合わせを学習させ、機械学習モデルを作り上げていきました。

感情認識AIの種類と活用分野

感情認識AIは、テキスト、音声、表情、生体情報など、様々なデータを基に人間の感情を分析することが可能です。

これらの技術は、ビジネス、医療、教育など多岐にわたる分野で活用され、コミュニケーションの質を向上させることが期待されています。ここでは、それらについて詳しく解説します。

テキストによる感情認識

テキストによる感情認識は、入力された文章から感情を分析する技術です。例えば、「最初は不安だったが、結果的にはとても楽しめた」という文は、ポジティブな感情を示しています。

一方で、「雰囲気は良かったが、全然馴染めなかった」という文は、ネガティブな感情を表しています。このように、言葉の選び方や文脈によって、感情を正確に読み取ることが可能です。

この技術は、特にビジネスの分野での活用が期待されています。例えば、カスタマーサポートにおいて、チャットボットが顧客の感情を理解し、適切な対応を行うことで、顧客満足度を向上させることができます。

また、マーケティングにおいては、顧客のフィードバックを分析し、製品やサービスの改善に役立てることができます。感情認識AIを活用することで、企業は顧客の本音を把握し、より良いサービスを提供することが可能になることでしょう。

音声による感情認識

音声による感情認識は、単に言葉の内容を分析するだけでなく、声の大きさ、抑揚、イントネーション、ピッチなどの特徴をも考慮に入れます。これにより、話し手の感情状態をより正確に把握することが可能です。

例えば、同じ「ありがとう」という言葉でも、明るいトーンで発せられれば感謝の気持ちが強く伝わりますが、冷たい声であれば、形式的な感謝に聞こえることがあります。

この技術は、特にメンタルヘルスの分析やコールセンターでの対応において重要な役割を果たします。メンタルヘルスの分野では、音声の変化を通じて、うつ病や不安障害の兆候を早期に発見することが期待されています。

また、コールセンターでは、顧客の声のトーンや抑揚を分析することで、顧客の感情を理解し、適切な対応を行うことができます。これにより、顧客満足度の向上や、オペレーターのストレスの軽減にも貢献することでしょう。

動画や写真による感情認識

動画や写真を用いた感情認識AIは、表情の変化を解析することで感情を特定します。

具体的には、瞳孔の大きさ、視線の動き、唇の動きなどの生理的な反応を捉え、これらのデータをもとに感情を推測します。この技術は、様々な活用シーンでの応用が期待されています。例えば、企業内でのストレスチェックにおいて、従業員の表情をリアルタイムで分析することで、メンタルヘルスの状態を把握し、早期の対策を講じることが可能です。

また、広告業界では、ユーザーが広告を見た際の表情を解析することで、どのような感情を抱いているかを理解し、広告の効果を最大化するための戦略を立てることができます。このように、動画や写真による感情認識は、ビジネスや医療をはじめとする様々な分野で活用の幅が広がっています。

生体情報による感情認識

生体情報による感情認識は、脳波、心拍数、発汗などの生理的データを解析することで、個人の感情状態を特定するAI技術です。この技術はまだ発展途上にありますが、特に医療分野での活用が期待されています。

例えば、脳波を測定することで、ストレスや不安のレベルを定量的に評価することが可能です。また、心拍数や発汗の変化を追跡することで、感情の変動をリアルタイムで把握することができます。

医療現場では、患者のメンタルヘルスを支援するために、この技術が役立つと考えられています。うつ病や不安障害の診断や治療において、感情の変化を客観的に評価する手段として利用が期待されています。

また、ストレス管理プログラムやリラクゼーション技術の効果を測定するためにも、生体情報の解析が有効です。このように、生体情報による感情認識は、今後の医療や心理学の分野で重要な役割を果たすことでしょう。

マルチモーダルの感情認識

感情認識技術の進化に伴い、複数の情報源を組み合わせた「マルチモーダル」アプローチが注目されています。マルチモーダルとは、テキスト、画像、音声などの多様な情報を統合的に組み合わせることで、より深く理解する技術です。

例えば、オンライン会議において、参加者の発言内容や声のトーン、さらには顔の表情を同時に解析することで、その人の感情状態をより正確に把握することが可能になります。

NTTドコモが開発したAI『AI suite』は、会議中の参加者の感情をリアルタイムで分析し、コミュニケーションの質を向上させることを目指しています。このようなマルチモーダルの感情認識技術は、ビジネスシーンだけでなく、教育や医療などさまざまな分野での応用が期待されています。

複数のデータソースを活用することで、感情の微妙な変化を捉え、より深い理解を促進することができるのです。このように、マルチモーダルの感情認識は、今後のAI技術の重要な方向性となるでしょう。

感情認識AIの応用例

実際に感情認識AIが、どのような分野で役立っているのか、その実例をいくつか紹介しましょう。人間の感情と直接相対する仕事である、カスタマーサービス、医療、そして人を楽しませるエンターテインメントなどの例があります。

顧客サービス

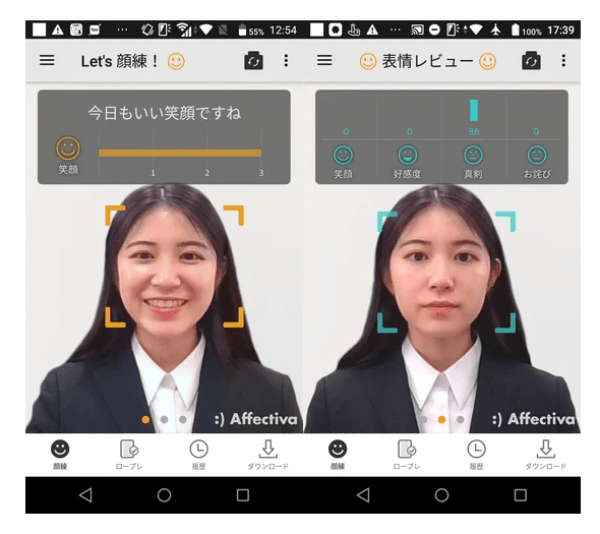

画像引用:Affectiva

感情認識AIは、営業窓口などで、顧客対応に当たる社員の表情のトレーニングにも使用されています。

明治安田生命保険相互会社(以下、明治安田)では、営業職員が外出する際に笑顔をチェックしたり、ひとりでも行えるセルフトレーニングをしたりできるようにCACの「心sensor for Training」を導入しました。

>>活用事例|Affectiva×シーエーシー明治安田生命様 営業向け表情トレーニングに心sensor for Trainingを採用

全国約3万8千人の営業職員の業務用スマートフォンにインストールして使用しており、営業職員はスマートフォンの画面を見ながら、感情表現の練習ができるようになっています。カメラを作動させたスマートフォンに向かって話をすることで、その時の表情をAIがリアルタイムに分析して採点し、振り返りに役立てています。

また、明治安田ではCAC独自開発のSpeech Rating Systemを使い、AIで発話の練習もできるように共同開発し、すでにスピーチ採点機能として実装しています。商談は緊張するものですが、日々AIでトレーニングを積むことで自信をもって商談に臨めるでしょう。

ヘルスケア

ヘルスケアの分野で活躍する感情認識AIは、障害を持った子どもたちのケアなどに役立っています。Brain Power(ブレインパワー)社は、Affectiva社のソフトウェア開発キット(SDK)を使って自閉症患者のための社会的スキルや認知能力の学習を支援するAR(拡張現実)スマートグラスシステムを開発しました。

>>活用事例|Affectiva×シーエーシー Brain Power

感情は人間の表情や言葉の調子に表れますが、自閉症の患者は人の感情を読み取るのが難しいため、これを学習するための教材をARスマートグラスで開発したのです。

患者がこのスマートグラスをかけると、会話する相手の表情が認識されて、「この表情は、どんな表情?」というクイズがアイコンで表示されるゲームが始まります。正解するたびに、患者は表情と感情の組み合わせを認識していける仕組みになっています。

エンターテインメントとゲーム

© 2023 SQUARE ENIX CO., LTD. All Rights Reserved.

音声・言語解析AIがゲーム開発に多大な貢献をしている事例があります。音声感情解析AI『Empath』は、ゲーム開発時にかかる表情アニメーターの工数を95%削減することに成功したのです。

これは、2024年1月に発売されたゲーム「FORSPOKEN」の開発時に活用された技術です。ゲーム中の3Dキャラクターの表情は、セリフを聞きながらアニメーターの手作業によって作成していたため非常に時間がかかりコストが高くなっていました。

『Empath』は収録したセリフを解析し、感情を数値で生成する技術を開発してゲーム会社に提供しました。その技術は、『Empath』の持つ感情を表す音声をもとにディープラーニングで、平常、怒り、恐怖など9つの感情を推定するものです。

これにより、1000分のセリフを処理するのに500人日の労力が必要だった作業が、25人日の労力でできるようになると想定できます。

感情認識AIの技術的挑戦と倫理的考慮

感情認識AIは画期的技術であり、これから様々な分野で活用されることが期待されますが、いくつかの課題も残されています。技術的には、精度の向上やマルチモーダルデータの統合が課題となっています。倫理的には、プライバシーの保護やデータの取り扱い、バイアスの問題が重要な課題です。

技術的挑戦

感情認識AIにおける技術的挑戦として、マルチモーダルへの挑戦が挙げられます。

マルチモーダルにより、画像のみ、音声のみなどの単一のデータソースだけでは捉えられない感情のニュアンスや複雑さを明らかにすることが可能になり、感情認識AIはより包括的な感情理解を達成することができるようになります。

画像だけでは見分けることができない感情を正しく判別するには音声も必要になる場合があることを、我々は経験的に知っています。普通の顔をしているのに、声が怒っている人を見たことはないでしょうか。こうした場合でも顔の表情の映像と音声の波形データの両方をもって感情認識ができれば、認識の精度はさらに高まるはずです。

前述したようにNTTドコモを始め、こうした試みは各企業で始まっており、感情認識AIの精度のさらなる向上が期待されています。

倫理的考慮

感情認識AIの発展は、多くの倫理的な課題を内包しています。その1つがプライバシーの保護です。

感情がデータ化されて記録されることは、個人の内面的な状態という私的な情報が社外に提供されることになります。表情が無断で収集されたり、それが漏洩したりするなどの可能性を含んでいます。

また、感情認識AIが不正確、あるいは偏った結果を出すことによる誤解や偏見の問題もあります。AIが特定の感情表現を誤って解釈すれば、不当な扱いや判断につながる可能性があります。

さらに、感情認識AIの使用目的に関する透明性についても配慮が必要です。企業や政府がこれらの技術をどのように使用しているかが明確でない場合、社会に対する信頼を損なう可能性があります。例えば、感情認識AIを用いた監視や評価システムが、個人の自由や権利を侵害する形で利用される危険性もあるでしょう。

これらの課題を解決するためには、次のような対処が望まれます。

・感情認識AIの開発と使用に関する倫理ガイドラインの策定

・データの収集と処理における透明性の確保

・利用者の同意の徹底、個人データの保護の優先

他にも感情認識AIに対して人種や性別、年齢などによってバイアスがかからないようにアルゴリズムを構築することも必要になるでしょう。また、AIが生成する結果の精度と公平性を高めるための技術や運用体制も求められます。

実際に、感情認識AIを取り扱う企業はデータの利用目的の開示などを行い、プライバシーに配慮した運用を行っています。

参考:J-Stage「文化と感情:比較文化的考察と組織論への意義/内田由紀子」

感情認識AIの未来

感情認識AIの未来は、大きな社会変化をもたらすことが予想されます。技術の進化は、より精密で人間に近いAIの感情理解を可能にし、働き方や生活の質が向上する可能性があります。

技術の進化の方向性

感情認識AIは、技術の進化によって大きく変貌することが予想されます。コンピュータのハードウェア性能の向上や通信速度の向上に伴って、機械学習やディープラーニングの速度や量が進歩して学習量は巨大なものになっていくでしょう。

これに伴って感情認識の精度はさらに上がっていきます。マルチモーダルアプローチの発展により、表情、音声、テキストのデータを同時に分析できるようになれば、普通の人間なら見過ごしてしまいそうな感情の動きを、機械が認知できるようになるかもしれません。

こうしたレベルにまで進化した感情認識AIはさらにその応用範囲を広げるでしょう。例えば感情データを利用した、個人の健康やウェルビーイングをサポートする方向へと進化する可能性があります。ストレスやうつ病の早期発見、心理的なサポートの提供など、ヘルスケア分野での応用も考えられます。

例えば、2013年頃に東日本大震災の被災地で復興支援にあたるボランティアスタッフに向けて、『Empath』を活用したメンタルヘルスケアを提供しました。厳しい環境のもとでメンタルに不調を抱えてしまう方がいるため、メンタル不調者を早期に発見して休みを取ることを促す取り組みを行っていました。

さらに、教育や仕事の環境においても、個人の感情や状態を理解し、適切なサポートやフィードバックを提供することで、学習効率の向上や職場の生産性の向上に貢献することができるでしょう。また、小売業やサービス業などでは、より人の感情に配慮したサービスが実践されるようになるはずです。

感情認識AIの技術的進化はこのように社会にポジティブな結果をもたらすことが期待されると同時に、先に述べたようなプライバシーの課題も考えられます。双方のバランスを保ちながら発展していくことが望まれます。

まとめ

感情認識AIは人の感情を読み解くことができる画期的な技術で、すでに各方面で実用化が進んでいます。

さらに今後は、顧客サービス、教育、ヘルスケアなど多くの分野で、人と人、人と機械の間のやりとりを、より人の感情に沿った形で実現し、社会にポジティブな影響をもたらすのかもしれません。しかし、これにはプライバシー侵害やデータの不正利用といった倫理的課題への対応が必要となります。

感情認識AIの未来は、技術の進歩と倫理的な管理のバランスをどのように取るかにかかっています。社会全体での議論と合意形成が、感情認識AIを使いこなす明るい未来を創造するカギとなるでしょう。

クリックして詳細を確認する

関連記事

感情認識AIが世界を変える 様々な分野での活用事例を紹介

表情分析の仕組みとは? 感情認識との関係、最新の研究事例や実用化が進む分野を紹介

動画解析の仕組みとは? 導入するメリット・デメリットを解説

顔面動作符号化システム(FACS)とは? 表情分析の仕組みと活用事例を紹介

姿勢推定とは? 活用シーンや手法、サービス事例を解説